Datamaskinens historie

Charles Babbage var matematiker. I 1821 arbeidet han ved observatoriet i Greenwich ved London. Da han kikket gjennom noen astronomiske tabeller som ble brukt av navigatørene for å bestemme et skips posisjon på havet, oppdaget han en feil. Ikke bare én, men en hel rekke feil.

Dette var midt i den industrielle revolusjon. Dampmaskiner drev spinnemaskiner, trykkpresser og mange andre innretninger som avlastet arbeiderene og økte produksjonen. Det var mens han satt og rettet opp alle feilene, at tanken slo ned i ham: Hva om han kunne lage en maskin som kunne mekanisere beregningene og fjerne alle menneskelige feil?

Resten av livet brukte Babbage på å utvikle denne «differansemaskinen», som han kalte den. Han var ingen riktig gjennomfører, og maskinen ble aldri bygd. Men etter flere forsøk hadde han tegningene ferdig. Han hevdet at den skulle kunne løse komplekse ligninger og gi svar med opptil 31 desimaler.

Ekspertene mente at den aldri kunne bygges. Helt til i 1980-årene. Da ble den faktisk bygd ved London Science Museum etter tegningene til Babbage. Maskinen veide fem tonn. Den var over tre meter lang og inneholdt 8 000 kamaksler og tannhjul laget av bronse, støpejern og stål. Og den virket!

Charles Babbage regnes i dag som datamaskinens far.

Visste du at den aller første programmereren var en kvinne?

Grevinne Ada Lovelace var matematiker og tidligere elev av Babbage. Hun hjalp til med å utvikle den første algoritmen til et av datamaskindesignene hans. En algoritme er en «oppskrift» som i et språk den forstår, trinn for trinn forteller datamaskinen hvordan den skal utføre en oppgave. Dataspråket Ada har fått navnet sitt til minne om henne.

«Tallenes fortryller» kalte Babbage henne. Mens han selv var opptatt av å bygge en maskin som kunne gjøre beregninger med tall, forutså Ada Lovelace at den i framtiden også kunne brukes til andre oppgaver.

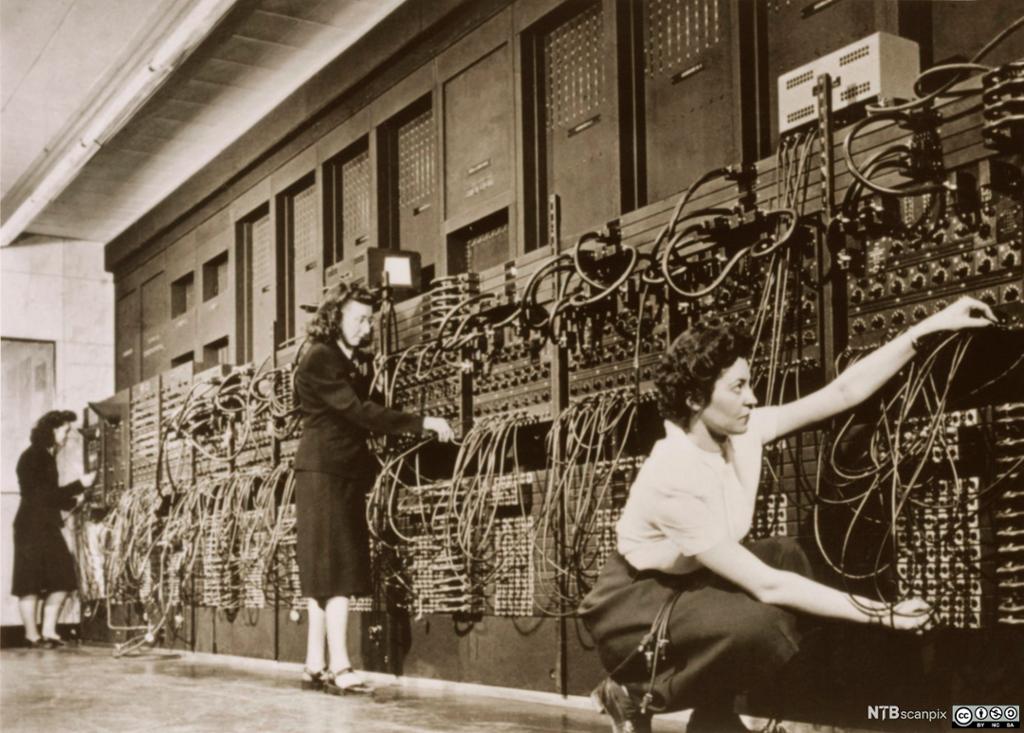

Det ble sagt at ENIAC var en svært personlig datamaskin. Ikke fordi man kunne bære den med seg, men fordi man kunne bo inni den!

ENIAC var 30 meter lang og nesten 3 meter høy, den veide 30 tonn, inneholdt 17 468 radiorør og kunne utføre 100 000 kalkulasjoner i sekundet. Man kunne vandre omkring i den og se på mens programmene ble utført.

Det ble bygd flere mekaniske datamaskiner i første halvdel av 1900-tallet. De var ikke så avanserte som den Babbage hadde tegnet, men kunne brukes til å håndtere store tallserier fra folketellinger og i bank- og forsikringsbransjen. IBM var en av produsentene.

Da krigen kom, økte behovet for avanserte beregninger. Koder skulle knekkes, og våpen gjøres mer treffsikre. For å få til det måtte den nye elektroniske teknologien utnyttes. Det ble brukt store ressurser på å utvikle digitale datamaskiner. Amerikanerne bygde ENIAC og IBMs Mark I. Engelskmennene bygde en de kalte Colossus.

Det var på denne tiden noen av de begrepene vi forbinder med data, ble formet. Ordet «computer» («beregner») ble opprinnelig brukt om de matematikerne som utførte ballistiske beregninger i våpenindustrien. Nå overtok ENIAC den jobben. På en time kunne den gjøre like mange beregninger som 50 matematikere klarte på et helt år. Ikke så underlig at det heretter var maskinene som gikk under navnet «computer».

Alle radiorørene inne i datamaskinene utviklet varme som kunne virke tiltrekkende på møll (bugs). Da måtte teknikerne inn i maskinen for å finne insektene og fjerne dem. Denne jobben kalte de «debugging». Ordet brukes fremdeles om å rette opp feil («bugs») i dataprogrammene.

Det er ingen tvil om at datamaskinen var en revolusjon. Men lenge var den som boka før Gutenberg: Den var forbeholdt de få, som militæret og bank- og forsikringsbransjen. Ikke så rart kanskje, når du tenker på hvordan maskinene så ut. Radiorørene gjorde dem enormt store og krevde mye vedlikehold. I 1950-årene overtok transistorene for de ømfintlige radiorørene. Maskinene ble kraftigere, men ikke rimeligere. Fremdeles måtte hver eneste transistor loddes til kretskortene for hånd.

Det var den integrerte kretsen, datachipen eller databrikken, som gjorde det mulig å masseprodusere datamaskiner. Akkurat som trykkpressen senket den kostnadene og satte i gang en kommunikasjonsrevolusjon.

I 1959 klarte Robert Noyce å trykke kretser med transistorer på de forskjellige lagene i en silisiumbrikke. Sammen med Jack Kilby regnes han som oppfinneren av databrikken. I 1968 startet han firmaet Intel i det området utenfor San Francisco som har fått navnet Silicon Valley.

Militæret var også denne gangen blant de første kundene. De trengte styringssystemer som var så kompakte at de kunne plasseres i en rakett, og de hadde råd til å betale flere tusen dollar per brikke.

I 1978 introduserte Intel brikkene 8086 og 8088. Det var disse brikkene som ble brukt i de første pc-ene til IBM.

I 1960- og 1970-årene var det mange som fryktet datamaskinenes voksende «superhjerner». De var redde for at makthaverne i samfunnet skulle bruke dem til å skaffe seg totalitær kontroll over innbyggerne, slik George Orwell hadde beskrevet det i boka 1984.

Mange sentrale utviklere var en del av den opprørske protestgenerasjonen i 1960- og 1970-årene. De lette etter måter å utvikle teknologien på slik at vanlige folk fikk makt over den. Dette opprøret mot «Storebror» kan altså ha vært en årsak til at datamaskinene utviklet seg til personlige maskiner som folk flest kunne bruke, og at internett fikk den åpne arkitekturen det har hatt til i dag.

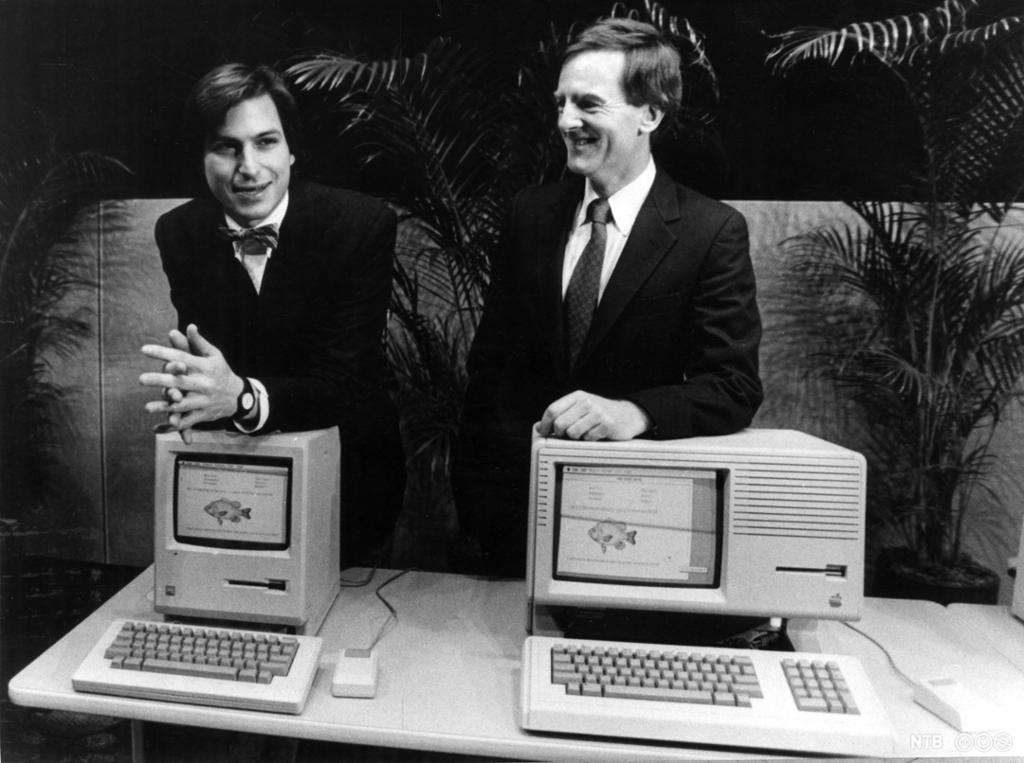

Men hvordan skulle helt vanlige folk kunne kommunisere med programmene og kretsene i en datamaskin? Det var en av utfordringene den unge hippien Steve Jobs bestemte seg for å løse.

Sammen med Steve Wozniak hadde han startet firmaet Apple Computers i 1977 for å selge en ganske primitiv, men likevel revolusjonerende hjemmedatamaskin som Wozniak hadde konstruert. Den neste modellen, Apple II, ble en stor suksess og gjorde de to bedriftseierne til millionærer. Maskinen var programmerbar, hadde en «killer application», et regnearkprogram kalt VisiCalc, og et design som så ut som en «dings» folk ville ha lyst til å ha hjemme.

I 1979 besøkte Jobs og en gjeng med ingeniører fra Apple forskningssenteret PARC som Xerox hadde etablert i Silicon Valley. Folkene fra Apple fikk se en maskin med et grafisk brukergrensesnitt (GUI). Det hadde et «skrivebord» og vinduer som viste innholdet i forskjellige filer, og en mus man kunne bruke til å peke på objektene på skjermen. De så en tekstbehandler som presenterte dokumentet på skjermen akkurat slik det ville bli når det ble skrevet ut på papir. Og de så Ethernet, et system som gjorde det mulig å lenke sammen datamaskiner, skrivere og kopimaskiner.

Steve Jobs forsto øyeblikkelig at dette var det som skulle til for å gjøre datamaskinen tilgjengelig for alle. Etter fire års arbeid kunne han stolt presentere maskinen Macintosh, som inneholdt alle de nyvinningene han hadde sett hos PARC.

Maskinen ble lansert med en reklamefilm som er blitt stående som en av de mest kjente noensinne. Den viser en sal full av grå, uniformerte funksjonærer. Foran i salen holder lederen en tale på en enorm fjernsynsskjerm. En ung kvinne kommer løpende gjennom salen og knuser skjermen med en slegge. Teksten lyder: «You’ll see why 1984 won’t be like ‘1984’.»

Data – det var IBM det. Sånn var det i 1970-årene. IBM var den største leverandøren av store datamaskiner til næringslivet og det offentlige. Suksessen med Apple II tok dem på sengen og fikk dem til å kaste seg inn i utviklingen av datamaskiner for folk flest. For å komme raskt på markedet fikk de et lite firma i Seattle til å lage operativsystemet. Firmaet var startet av en ung nerd ved navn Bill Gates. Navnet var Microsoft.

Selv om Windows ikke var så polert som Macintosh, og pc-klonene ikke så velbygde, gjorde den lavere prisen at de raskt fikk en dominerende plass i markedet. Mens Jobs ble presset ut av Apple og selskapet var på konkursens rand i 1996, ble Gates i 1987 verdens yngste «self-made» milliardær, og Microsoft etter hvert verdens mest verdifulle selskap.

Tenk deg at du lever i 1970-årene og har fått i oppdrag å lage et medlemsblad for idrettslaget ditt. Du tar noen bilder og leverer filmen til framkalling i en fotobutikk. Manus skriver du på papir på en skrivemaskin. Trykkeriet leverer det videre til et satsbyrå som taster det inn på nytt i en fotosatsmaskin til noen hundre tusen kroner. Bildene sendes til en reproanstalt og skannes på en maskin til noen millioner. En designer på trykkeriet forstørrer eller forminsker overskrifter og illustrasjoner i et reprokamera til noen titusener, klipper opp strimlene med fotosats og limer alt sammen til sider på et stort lysbord. Til slutt lager de filmer og trykkeplater før de endelig kan sette de svære trykkpressene i gang.

Alt dette kan du i dag gjøre selv med et digitalkamera, en rimelig pc og en printer. Et helt trykkeri på ditt eget skrivebord. Velkommen til desktop publishing.

Etter hvert som datamaskinene ble kraftigere, spredte desktop-revolusjonen seg til andre bransjer. Photoshop gjorde mørkerom og fotolaboratorier overflødige. MIDI, sekvensere og andre lydprogrammer skaffet musikeren et helt lydstudio på laptopen sin. Filmklippebord, miksebord og svære videospillere i film- og tv-bransjen kunne skrotes.

På bare noen få år forsvant spesialiserte yrkesgrupper i mediebransjen. Oppgaver som før bare kunne utføres av fagfolk med lang opplæring og dyrt utstyr, kunne nå gjøres av hvem som helst med en pc og litt programvare. Det har gitt flere stemmer muligheten til å bli hørt og skapt et større mangfold av uttrykk, men kanskje også ført til lavere kvalitet.

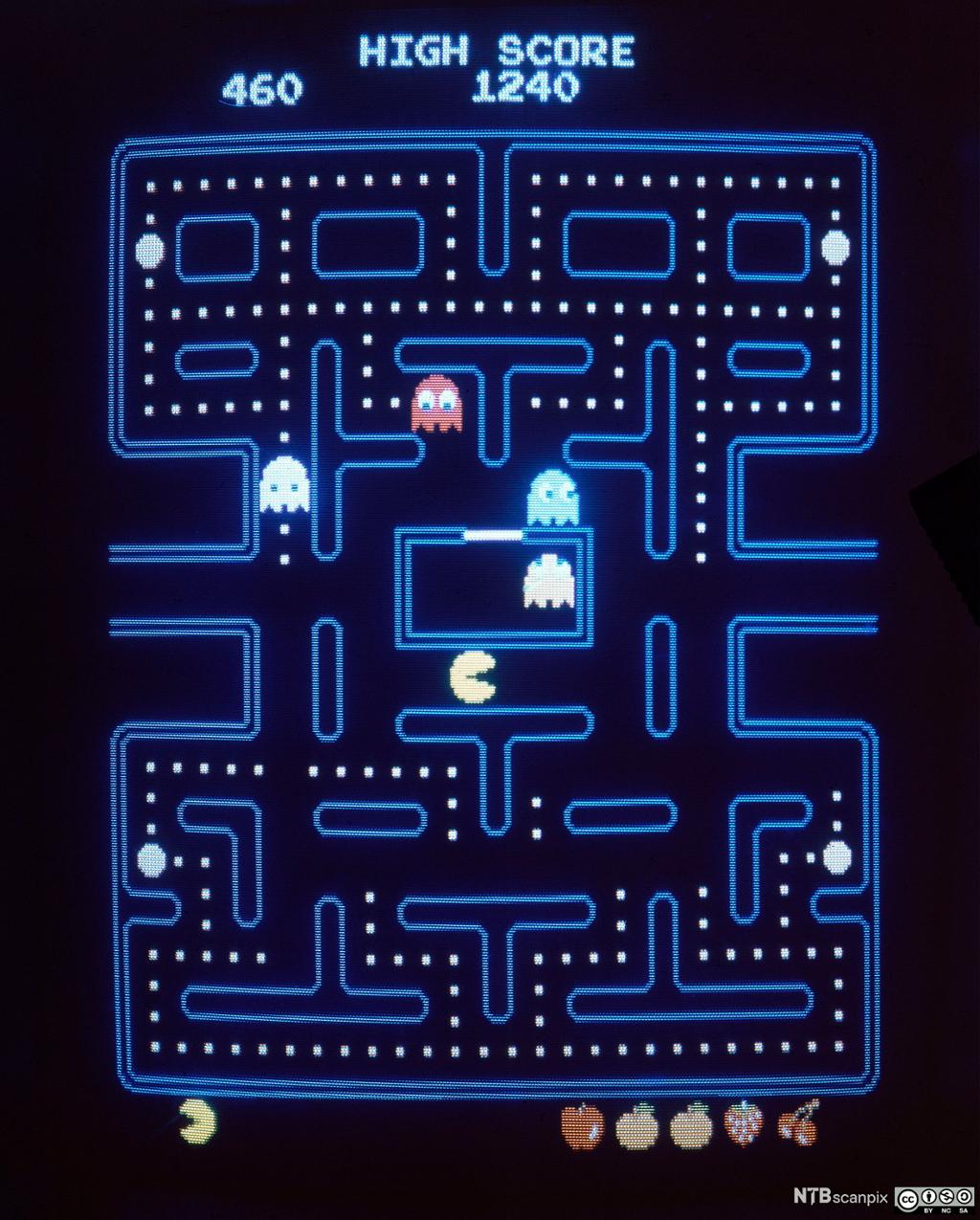

Lek er et så viktig trekk ved mennesket at det finnes et eget latinsk uttrykk for det: Homo ludens, det lekende mennesket. Det er derfor ikke så overraskende at noen fant på å lage spill allerede på de svære datamaskinene i 1950- og 1960-årene.

Folk flest spilte «arkadespill» på spilleautomater og «videospill» på konsoller som de koblet til tv-en. Det kjente spillet Pac-Man ble skapt som arkadespill i 1982. To år senere lanserte Atari det for spillkonsollen sin og solgte sju millioner.

Det var på den tiden hjemmedatamaskinene gjorde sitt inntog. Commodore 64 (1982), Commodore Amiga (1985) og etter hvert IBM PC (originale eller kloner) hevet stadig listen for hva som var mulig å få til både av grafikk og lyd. Det ga nye muligheter til spillutviklerne, som svarte med en rekke nye sjangere. Det første skytespillet, Wolfenstein 3D, kom i 1992. Doom fra året etter var et gjennombrudd for 3D-grafikk. CD-ROM som erstattet diskettene på den tiden, gjorde det mulig å levere spill med mer bilder, lyd og video til brukeren, noe det populære eventyrspillet Myst benyttet seg av.

Utviklingen av raske grafikkort og teknologier som DirectX og OpenGL har gjort det mulig å skape stadig mer realistiske 3D-verdener på skjermen. Mye av utviklingen i spillene de siste årene har handlet om bedre 3D-grafikk. Samtidig har internett og bredbånd gjort såkalte MMORPG-spill (Massively MultiPlayer Online Role-Playing Game) mulig. Et eksempel du sikkert kjenner, er World of Warcraft fra 2004. Simulatorspill er etter hvert blitt så virkelighetstro at for eksempel et spill som Microsoft Flight Simulator til noen hundrelapper kan brukes i opplæringen av virkelige piloter.

De kraftige pc-ene har ikke gjort spillkonsollene overflødige. Både Atari, Nintendo og Microsoft har produsert populære konsoller. Etter at iPhone ble lansert i 2007, har også Apple tatt en stor bit av markedet.

I Norge støttes spillbransjen av Kulturdepartementet, og e-sport er blitt en anerkjent idrett.

«I framtiden kommer kanskje ikke datamaskinene til å veie mer enn 1,5 tonn», skrev bladet Popular Mechanics i 1949. I 1970-årene hadde den krympet så den fikk plass på et skrivebord. Siden 2007 har du gått rundt med den i lommen. Det året lanserte Apple sin første iPhone, med operativsystemet iOS. Tre år senere kom iPad. Google lagde operativsystemet Android, som driver smarttelefoner og nettbrett fra andre produsenter.

Mobile enheter lagrer ikke lenger dataene på en harddisk, men i «skyen», det vil si på servere som de er knyttet til gjennom mobile nettverk. Veksten i trafikken over det mobile nettet som en gang var beregnet for tale, er enorm, og stiller store krav til leverandører av telenett.

Også måten vi samhandler med maskinene på, er i endring. Musen, som kanskje var den fremste av de oppfinnelsene som gjorde den personlige datamaskinen mulig, ble først erstattet av pekeskjermer. I dag kan man styre maskinene ved hjelp av stemme eller øyebevegelser.