Bildegenerering med kunstig intelligens

Å definere kunst er en utfordrende oppgave. Synet på kunst endrer seg stadig, og over tid har begrepet blitt både bredt og omfattende. For eksempel hadde den anerkjente kunsten gjerne religiøse motiver i middelalderen, mens kunstnerne i romantikken la vekt på å formidle følelser og skape originale uttrykk.

Mange forstår kunst som det vi kan se, høre eller oppleve som et resultat av en kunstners ferdigheter. Men er et kunstverk bare noe som laget for å gi tilskueren en opplevelse, eller kan det også være noe som har funksjonell bruk?

Utvikling av nye verktøy gir nye uttrykksformer. Grensa mellom hva som kan kalles kunst og ikke, blir stadig diskutert.

Diskuter

Hva mener dere er kunst?

Kan en datamaskin skape kunstverk ved hjelp av kunstig intelligens?

Hva skiller menneskelig kreativitet fra det en datamaskin kan skape ved hjelp av algoritmer?

Kunstneren er den som lager kunst. Kunstnerbegrepet har så langt hovedsakelig vært forbeholdt mennesker, men enkelte dyr ser ut til å ha glede av å lage bilder. Kan vi da kalle en apekatt en kunstner?

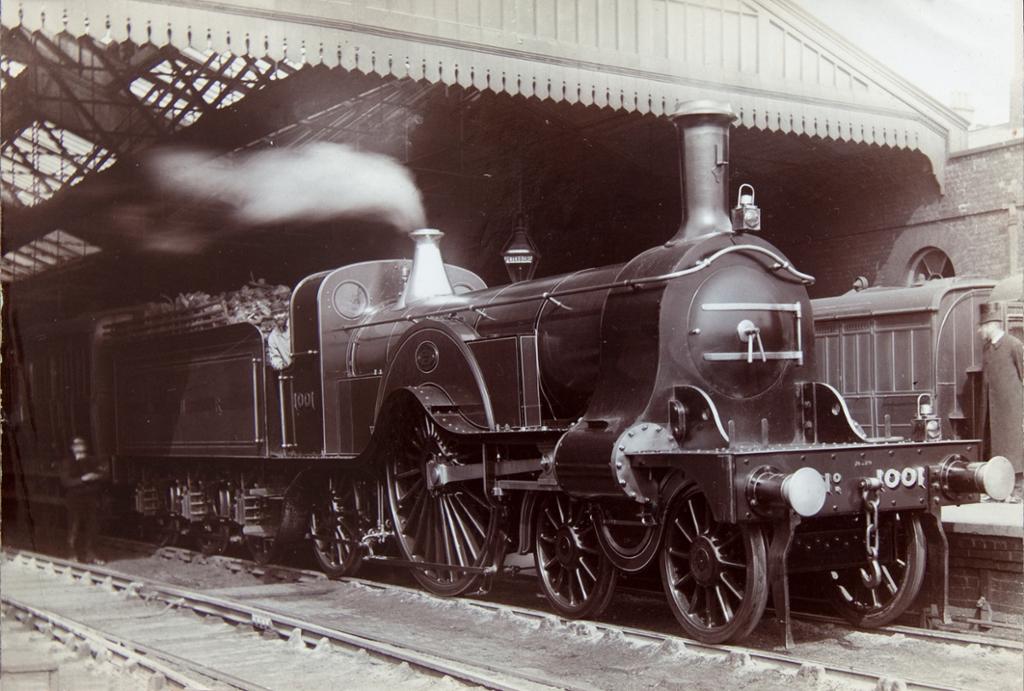

I nyere tid gjør kunstig intelligens det mulig for datamaskiner å lage det mange vil kalle for kunst. Ved å sette sammen data på nye måter kan maskinene skape originale bilder.

For bildegenerering brukes spesialiserte maskinlærings-algoritmer som er trent opp på store mengder bilder og tilhørende stikkord (tags). Vi kaller slike algoritmer for modeller (på engelsk: model eller checkpoint).

Modellen er i stand til å koble stikkordene til elementer i bilder som stil, komposisjon og objekter i bildet. Vi kan dermed gi modellen en tekstbeskrivelse, en ledetekst, av hva vi ønsker i bildet, og modellen genererer et bilde som samsvarer. Derfor kaller vi teknologien for tekst-til-bilde-modeller (txt2img). Mange modeller kan i tillegg ta direkte utgangspunkt i et eksisterende bilde, manipulere bildet eller hente ut egenskaper fra det for å produsere et nytt bilde. Dette kaller vil bilde-til-bilde-modeller (img2img).

Stable Diffusion, Dall-e, Adobe Firefly og Midjourney er eksempler på store sentrale utviklere av bildegenereringsmodeller.

Trening av modeller

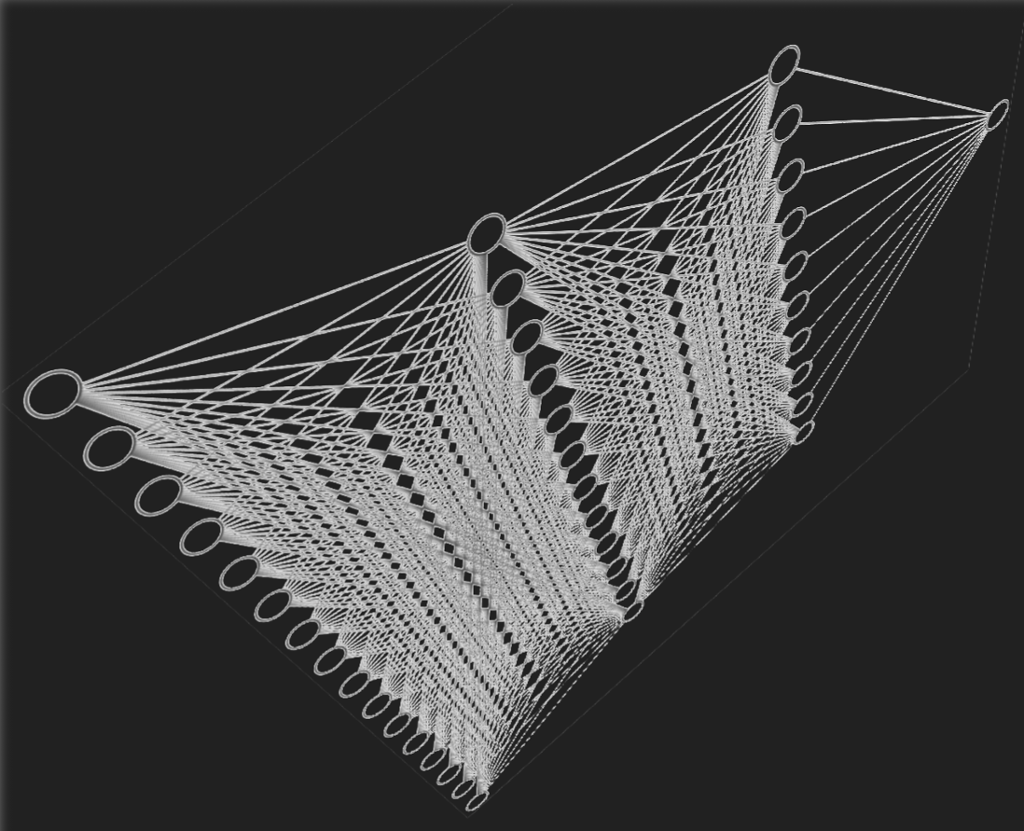

Modellene prøver å etterlikne hvordan menneskehjernen fungerer, og enkle algoritmer (utregninger) fungerer som nevroner som er koblet sammen. Båndene mellom nevronene har en bestemt styrke, og styrken bestemmer hvor sterk påvirkning nevronene har på hverandre. Et stort antall nevroner som er koblet sammen, kaller vi for et nevralt nettverk (neural network).

Styrken på båndene mellom nevronene i det nevrale nettverket er sentral for at modellen skal fungere. Modellene må trenes for at verdiene skal bli riktig. Modellene prosesserer store mengder ekte bilder med tilhørende stikkord (tags) som de så forsøker å gjenskape gjennom forskjellige iterasjoner. For hver iterasjon testes ulike styrker mellom nevronene. Mellom iterasjonene vurderes sluttresultatet mot tidligere forsøk. Modellen vurderer deretter sine egne produksjoner opp mot originalene og gjør justeringer. Det er også mulig å involvere andre allerede trente modeller eller mennesker til å hjelpe til med fintreningen av en modell.

Det er mulig å trene opp sin egen modell eller delmodell, men de fleste vil nok bruke en allerede eksisterende modell.

Bruk av modell

Vi har mange forskjellige tekst-til-bilde-modeller. Noen er proprietære, og vi må leie eller kjøpe tilgang (som oftest nett-tjenester eller innbakt i programvare). Andre er åpne, og vi kan kjøre modeller på egen maskinvare med kraftig nok skjermkort eller kapasitet leid hos en skytjeneste.

Når modellen kjører, gir vi den tekstbeskrivelser av det vi ønsker å få generert et bilde av.

Bildegeneratorer kan ha mange justeringsmuligheter og grader av brukervennlighet.

Du kan få gode resultater med begge løsninger, men for profesjonell bruk er de mer avanserte bildegeneratorene ofte å foretrekke.

Relatert innhold

Her får du en kort innføring i begrepet algoritmisk tenking, og du får eksempler på hva en algoritme kan være.

Hva er kunstig intelligens? Hvordan kan vi øve oss i kritisk tenkning og forstå etiske problemstillinger?